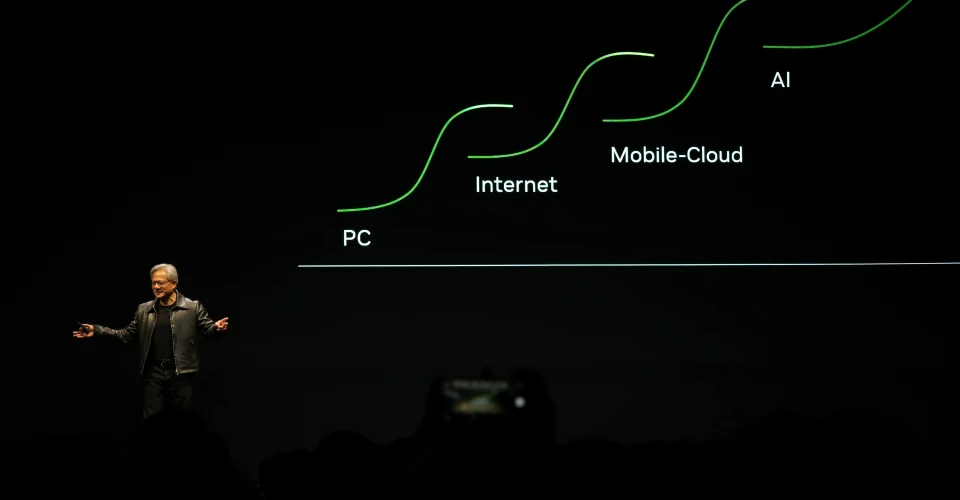

台北-NVIDIA的Computex主旨演讲是人工智能和数据中心创新的巡回演出。周一,NVIDIA在亚洲最大的IT贸易展(自2019年以来的第一个主要面对面展会)的“赛前”日拉开了序幕。而且,如果你相信NVIDIA首席执行官黄延森的话,这些举措将在未来几年触及每一个企业和每个行业。(华尔街似乎对此表示同意。)这是因为到目前为止,产生式人工智能正准备渗透到人工智能倡议未触及的公司和学科。正如我们所知,这项时髦的新技术也将改变软件开发。

NVIDIA的硬件和其他举措是当今人工智能领域发生变化的关键基础。加速计算是黄在主旨演讲中反复提到的主题。NVIDIA将加速计算定义为“使用专门的硬件来显著加快工作速度,通常使用并行处理来捆绑频繁发生的任务。”它被用于要求苛刻的领域,如机器学习、数据分析和模拟,而图形处理器是一种强大的、常见的加速器,使NVIDIA处于市场的核心。

黄指出,这是他自新冠肺炎疫情爆发以来第一次面对面的主旨演讲(祝我好运!)他还有很多东西要做:主旨演讲持续了整整两个小时,需要打开的东西比一整支足球队装满装备的拖车还多。我们将其归结为八大亮点。

1.“加速计算是可持续计算”

黄对GPU计算的崛起和潜力给出了一些看法,因为它与现在市场上的人工智能模型和功能有关。考虑到训练人工智能模型对计算能力的永无止境的需求,他使用了1000万美元作为基准。不久前,这笔钱可以买960台基于CPU的服务器,消耗11千兆瓦小时的电力来训练一个人工智能大语言模型(LLM),而现在同样的钱可以买48台基于GPU的服务器,使用大约三分之一的能源……并且有能力训练多达44个大型语言模型。

相反,就像他所说的那样,两台能够培训一名LLM的GPU服务器现在可以让你花费大约40万美元,而不是原来的1000万美元。这就是我们看到的变化规模,他表示,就后端处理人工智能的计算能力而言。

2.“任何有结构的东西,我们都能学会这种语言。”

在谈到人工智能和突然的转向,在外部观察者看来,就其影响而言,它可能像闪电一样从天而降,黄认为,该行业已经达到了一个临界点,在深度学习和分布式计算的交汇处遇到了这个临界点。

“任何有结构的东西,我们都可以学习这种语言,”黄指出。“我们现在可以将计算机科学应用到许多以前不可能的领域。”关键的一点是:人工智能跨越信息类型的能力。

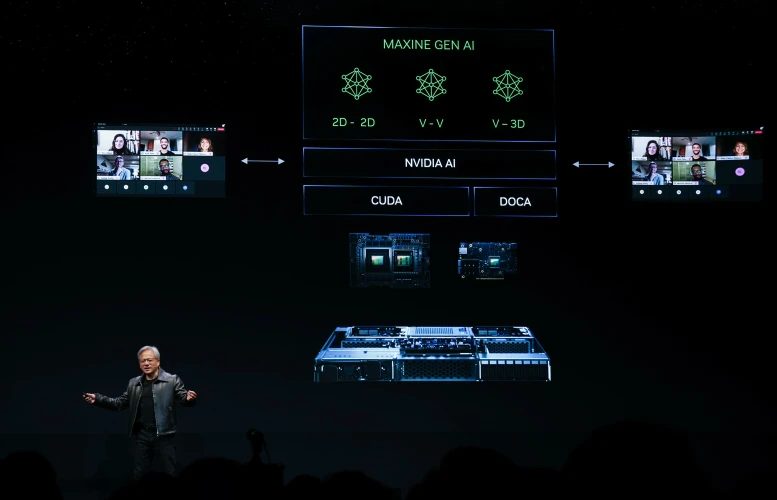

将人工智能带入公众意识的重大突破可能是像ChatGPT这样的容易理解的聊天机器人,但“跨内容类型”的人工智能应用程序暗示了一种更激进的影响:将文本转换为视频,将视频转换为文本,或将文本转换为音乐。这位NVIDIA首席执行官给出了一些发自内心的例子。在其中一段视频中,他放了一段文字,人工智能立即将其转化为一个看似真实世界的女人,在视频中说出了他的话。在另一段演示中,他通过对他想听的音乐类型的语音提示描述,生成了一系列大气的、台湾主题的传统音乐。除此之外,他还使用提示为一首顺口溜类型的歌曲创建了歌词,然后人工智能将其设置为音乐,然后启用了一个不同生成的版本,供观众在伴唱中使用。

总而言之:在这波最新的人工智能浪潮中,一些关键障碍已经被打破,包括信息类型之间的边界,以及利用一种信息操纵另一种信息的能力。当你考虑到其他一些可能的交叉:文本、代码,甚至DNA时,这其中的含义是深远的。

3.让游戏中的角色变得逼真

黄详细介绍了面向游戏开发商的NVIDIA阿凡达云引擎,或NVIDIA ACE。这项技术是为开发人员设计的,以便在游戏中生成和定制AI角色。角色模型经过预先训练,将准备好根据背景故事生成对话,人工智能可以借鉴这些背景故事,以生成一致性和现实感。(ACE框架内的指导方针将使对话保持在点上,并与游戏相关。)这里的想法是,最终,在给定的PC游戏的边缘,非玩家角色可能会通过像这样的人工智能生成的交互来处理,而不是通过脚本进行处理。

在NVIDIA的例子中,这个店主给出了一些与游戏情节相关的人工智能生成的背景对话:

当然,这可能听起来有点矫揉造作,但现在还为时尚早。此外,ACE采用了包括该公司的Omniverse Audio2Face在内的技术,用于制作NPC表情的动画。

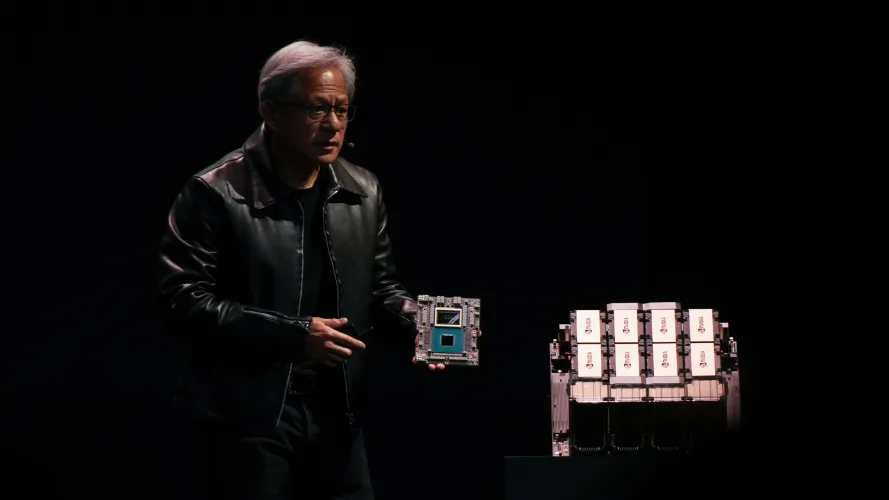

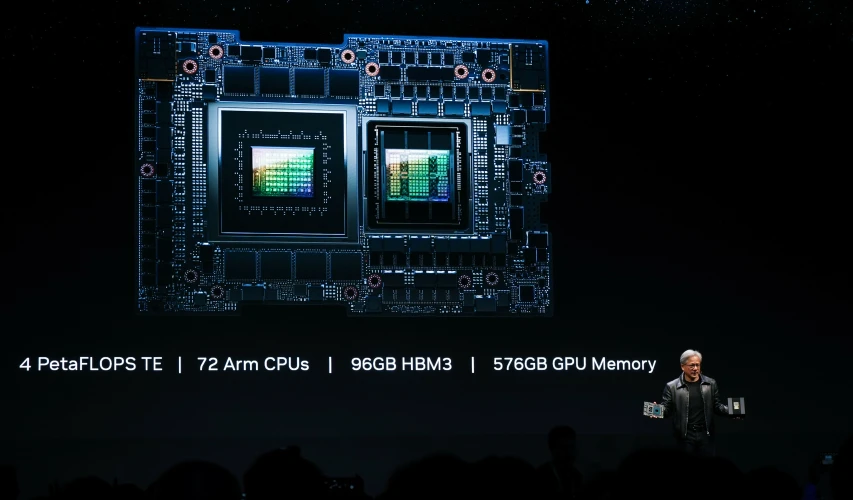

4.“格蕾丝·霍珀”加入聊天

黄宣布,NVIDIA的GH200“超级芯片”,也被称为“格蕾丝·霍珀”,正在生产中。(Grace Hopper通过高速互连将基于ARM的NVIDIA“Grace”CPU和基于NVIDIA“Hopper”H100张量核心的GPU整合到一个封装中。)GH200旨在支持加速计算,包括基于ARM的72核CPU、96 GB HBM3内存和576 GB显存。

黄吹捧了GH200上超过2000亿个晶体管,并提到软银的日本数据中心将把格雷斯·霍珀纳入其运营。

5.一台超级计算机,上面写着“Grace”

在格雷斯·霍珀的开发之后,黄详细介绍了NVIDIA DGX GH200。这是一个基于GH200的大规模超级计算机解决方案,用于生成性人工智能培训和LLMS,预计将于今年年底完成。最终,256个GH200 Grace漏斗连接在DGX GH200上。八人一组通过NVLink联系在一起。然后,反过来,这些小组中的32个,通过一层交换机连接,实质上创造了一个巨大的超级计算机规模的GPU,正如黄所说的那样。DGX GH200将拥有150英里长的光缆,拥有2000多个风扇,据黄说,它的重量是“四头大象”(4万磅)。

– – END – –

– – 转载请声明来源:www.lanpanpan.com – –

编译:盼盼云笔记